redisの型の認識が何気だったので改めて整理してみた。自分の頭の整理用に図も描いたりしたのでせっかくなので掲載。

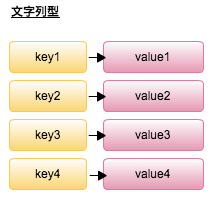

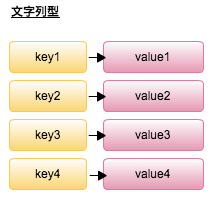

文字列型

一番シンプルな形。

127.0.0.1:6379> SET key1 value1

OK

127.0.0.1:6379> SET key2 value2

OK

127.0.0.1:6379> GET key1

"value1"

127.0.0.1:6379> GET key2

"value2"

127.0.0.1:6379> MGET key1 key2

1) "value1"

2) "value2"

expireを設定することもできるのでキャッシュとして用いる場合はこれを利用する。

127.0.0.1:6379> SETEX cache1 5 cache-val1

OK

127.0.0.1:6379> GET cache1

"cache-val1"

(5秒経過後)

127.0.0.1:6379> GET cache1

(nil)

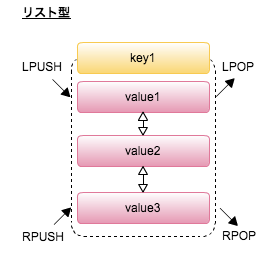

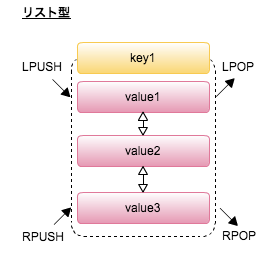

リスト型

双方向な線形リストで構成。要素の追加の方向は基本先頭か末尾。

これを利用することでスタックやキューを構成することができる。

LPUSH , LPOP を利用するとスタックを構成できる。LPOPで取り出されている要素を確認すると一番最後に格納した要素から取り出せている。

127.0.0.1:6379> LPUSH list1 1

(integer) 1

127.0.0.1:6379> LPUSH list1 2

(integer) 2

127.0.0.1:6379> LPUSH list1 3

(integer) 3

127.0.0.1:6379> LPOP list1

"3"

127.0.0.1:6379> LPOP list1

"2"

127.0.0.1:6379> LPOP list1

"1"

127.0.0.1:6379> LPOP list1

(nil)

RPUSH, LPOPを利用するとキューを構成できる。LPOPから取り出されている要素を確認すると最初に格納した要素が取り出せている。

127.0.0.1:6379> RPUSH list1 1

(integer) 1

127.0.0.1:6379> RPUSH list1 2

(integer) 2

127.0.0.1:6379> RPUSH list1 3

(integer) 3

127.0.0.1:6379> LPOP list1

"1"

127.0.0.1:6379> LPOP list1

"2"

127.0.0.1:6379> LPOP list1

"3"

127.0.0.1:6379> LPOP list1

(nil)

リスト操作

リストに対して部分操作ができる。例えば先頭から2要素を抽出するときは LRANGE コマンドを使う。

127.0.0.1:6379> RPUSH list1 1

(integer) 1

127.0.0.1:6379> RPUSH list1 2

(integer) 2

127.0.0.1:6379> RPUSH list1 3

(integer) 3

127.0.0.1:6379> RPUSH list1 4

(integer) 4

127.0.0.1:6379> LRANGE list1 0 1

1) "1"

2) "2"

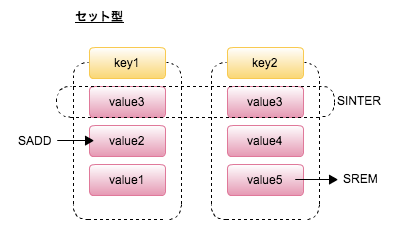

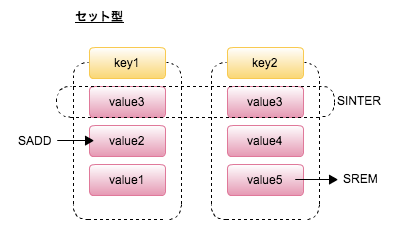

セット型

値の重複を許さない文字列型の集合で且つ集合同士の操作ができる。例えば SINTER コマンドを使うと積集合を得ることができる。

下の例だと集合 set1 と set2 に対して SINTER コマンドを発行すると両方の集合に対して属している 3 が取り出せている。

127.0.0.1:6379> SADD set1 1

(integer) 1

127.0.0.1:6379> SADD set1 2

(integer) 1

127.0.0.1:6379> SADD set1 3

(integer) 1

127.0.0.1:6379> SADD set2 3

(integer) 1

127.0.0.1:6379> SADD set2 4

(integer) 1

127.0.0.1:6379> SADD set2 5

(integer) 1

127.0.0.1:6379> SINTER set1 set2

1) "3"

ソート済みセット型

セット型で更にそれぞれの要素はスコアを持ち、そのスコアにもとづいてソートされた形で格納される。

127.0.0.1:6379> ZADD sortset 5 A

(integer) 1

127.0.0.1:6379> ZADD sortset 10 B

(integer) 1

127.0.0.1:6379> ZADD sortset 8 C

(integer) 1

127.0.0.1:6379> zrangebyscore sortset -inf +inf

1) "A"

2) "C"

3) "B"

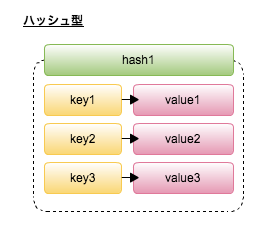

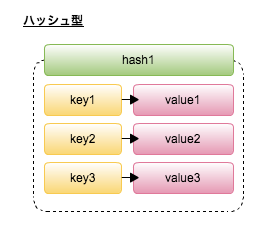

ハッシュ型

こちらはそのまま。集合内の要素は全てキーと値で一意となるハッシュとして管理される。

127.0.0.1:6379> HSET hash1 foo 10

(integer) 1

127.0.0.1:6379> HSET hash1 bar 20

(integer) 1

127.0.0.1:6379> HSET hash1 hoge 30

(integer) 1

127.0.0.1:6379> HGET hash1 foo

"10"

127.0.0.1:6379> HGET hash1 bar

"20"

127.0.0.1:6379> HGET hash1 hoge

"30"

127.0.0.1:6379> HGET hash1 hoge2

(nil)

最近のコメント