StrongLoopが開発したloopbackは、Node.jsで作られたフレームワーク(所謂mBaaSのオープンソース実装)で以下の様な特徴があります。

といった特徴があります。

利用実績としては、GoDaddyでpublic reseller APIに利用されている様です。

StrongLoop | GoDaddy Selects StrongLoop to Power Reseller API Platform

SPAなアプリケーションを2011年からREMPやSTOBO、

そしてRendrを利用してCastoを作ってきましたが、もしかしたらloopbackを使ってAPI開発をよりスムーズに

解決できるのではないか。という期待を抱きつつ試しに触ってみました。

ひとまずゴールとしては、

loopbackでアプリケーションを作成し、APIを介してユーザを作るところまで

とします。

準備

とにもかくにも strongloop コマンドをインストール。*1

$ npm install -g strongloop

これで slc コマンドが使える様になってscaffoldできます。

アプリケーション作成

実際にアプリケーションを作成してみます。(謎のキャラクターが表示されます)

☁ slc loopback remp-api

_-----_

| | .--------------------------.

|--(o)--| | Let's create a LoopBack |

`---------´ | application! |

( _´U`_ ) '--------------------------'

/___A___\

| ~ |

__'.___.'__

´ ` |° ´ Y `

? What's the name of your application? remp-api

? Enter name of the directory to contain the project: remp-api

create remp-api/

info change the working directory to remp-api

Generating .yo-rc.json

I'm all done. Running npm install for you to install the required dependencies. If this fails, try running the command yourself.

create .editorconfig

create .jshintignore

create .jshintrc

create README.md

(snip)

Next steps:

Change directory to your app

$ cd remp-api

Create a model in your app

$ slc loopback:model

Optional: Enable StrongOps monitoring

$ slc strongops

Run the app

$ slc run .

ユーザーモデルを作成

続いてユーザーを管理するためのモデルを作成してみます。

loopbackではいくつかのbase classが用意されていてその中にUserというクラスが存在するので今回はこれをこのまま利用します。

基本的なユーザ管理をする場合であればbase classのままでよいのですが、何か新たにプロパティ足したい場合は追加をすることもできます。今回はスキップ。

☁ slc loopback:model

? Enter the model name: user

? Select the data-source to attach user to: db (memory)

? Select model's base class: User

? Expose user via the REST API? Yes

? Custom plural form (used to build REST URL):

Let's add some user properties now.

Enter an empty property name when done.

? Property name:

☁

上の操作で以下の様な要素を持ったユーザ管理のモデルが作成できます。

| 要素 |

- |

| realm |

(string, optional) |

| username |

(string, optional) |

| credentials |

(object, optional) |

| challenges |

(object, optional) |

| email |

(string) |

| emailVerified |

(boolean, optional) |

| verificationToken |

(string, optional) |

| status |

(string, optional) |

| created |

(string, optional) |

| lastUpdated |

(string, optional) |

| id |

(number, optional) |

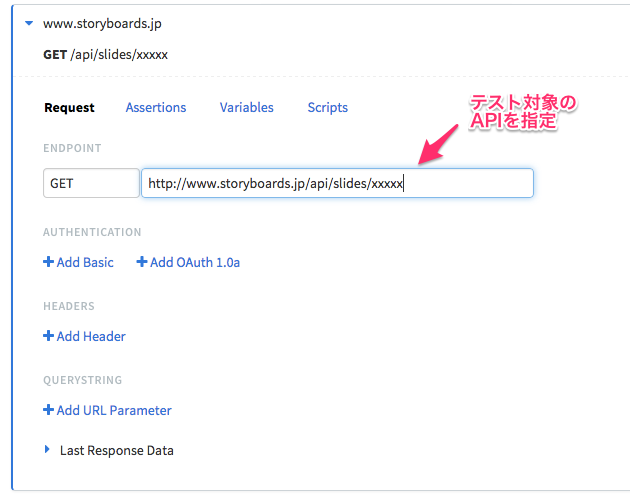

APIを呼び出してみる

では、モデルを作成 = API作成 ができたので実際にHTTPクライアントからAPIを呼び出してみます。

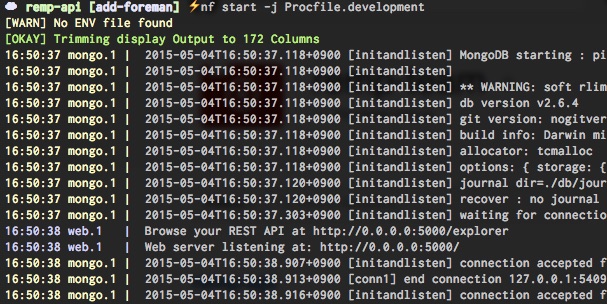

loopbackアプリケーションを起動します。

☁ node .

Browse your REST API at http://0.0.0.0:3000/explorer

Web server listening at: http://0.0.0.0:3000/

おもむろにloopbackアプリケーションを呼び出します。

先ほど作成したUserモデルに対応するAPIのエントリポイントは /api/users に対応しますので、そこへメールアドレスとパスワードをPOSTします。

☁ http -v POST http://0.0.0.0:3000/api/users password=hogehoge email=hideack@remp.jp

POST /api/users HTTP/1.1

Accept: application/json

Accept-Encoding: gzip, deflate

Content-Length: 52

Content-Type: application/json; charset=utf-8

Host: 0.0.0.0:3000

User-Agent: HTTPie/0.8.0

{

"email": "hideack@remp.jp",

"password": "hogehoge"

}

HTTP/1.1 200 OK

Access-Control-Allow-Credentials: true

Connection: keep-alive

Content-Length: 34

Content-Type: application/json; charset=utf-8

Date: Sat, 02 May 2015 05:27:48 GMT

ETag: W/"22-3085cb67"

Vary: Origin, Accept-Encoding

X-Powered-By: Express

{

"email": "hideack@remp.jp",

"id": 2

}

ステータスコード200が帰って来てユーザを作成することができました。

ログインしてみる

では、先ほど作成したユーザでログインしてみます。ユーザ作成の際に利用したメールアドレスとパスワードを要素としてPOSTします。

ログイン用のエントリポイントは /api/users/login なので、ここにユーザ登録の際に設定したメールアドレスとパスワードを渡します。

☁ http -v POST http://0.0.0.0:3000/api/users/login email=hideack@remp.jp password=hogehoge

POST /api/users/login HTTP/1.1

Accept: application/json

Accept-Encoding: gzip, deflate

Content-Length: 52

Content-Type: application/json; charset=utf-8

Host: 0.0.0.0:3000

User-Agent: HTTPie/0.8.0

{

"email": "hideack@remp.jp",

"password": "hogehoge"

}

HTTP/1.1 200 OK

Access-Control-Allow-Credentials: true

Connection: keep-alive

Content-Length: 135

Content-Type: application/json; charset=utf-8

Date: Sat, 02 May 2015 05:30:16 GMT

ETag: W/"87-4fc8ab24"

Vary: Origin, Accept-Encoding

X-Powered-By: Express

{

"created": "2015-05-02T05:30:16.742Z",

"id": "r3YFqmceF1INk5FlstmZgO7p2y42TyLYPlzSchPIDIDBlAbuOHQurS5j5gOSH82h",

"ttl": 1209600,

"userId": 2

}

ステータスコード200が帰って来て、API操作用のトークンが戻ってきました。なお、パスワードが誤ると、

HTTP/1.1 401 Unauthorized

{

"error": {

"code": "LOGIN_FAILED",

"message": "login failed",

"name": "Error",

"stack": "Error: login fail...",

"status": 401,

"statusCode": 401

}

}

となって期待通りです。

ログイン時のトークンを利用してユーザ情報を取る

続けて先ほどログイン時に取得したトークンを利用してユーザの情報を取得してみます。

現状だとUserモデルしか存在しないのでできることが少ないですがログインしているユーザ自身の情報を取ってみます。

/api/users/2?access_token=(ログイン時に得たtoken) に対してGETします。

☁ ~ http http://0.0.0.0:3000/api/users/2\?access_token\=r3YFqmceF1INk5FlstmZgO7p2y42TyLYPlzSchPIDIDBlAbuOHQurS5j5gOSH82h

HTTP/1.1 200 OK

Access-Control-Allow-Credentials: true

Connection: keep-alive

Content-Length: 34

Content-Type: application/json; charset=utf-8

Date: Sat, 02 May 2015 05:45:01 GMT

ETag: W/"22-3085cb67"

Vary: Origin, Accept-Encoding

X-Powered-By: Express

{

"email": "hideack@remp.jp",

"id": 2

}

scafoldする際に特にプロパティを追加していないのでidとemailのみ返ります。

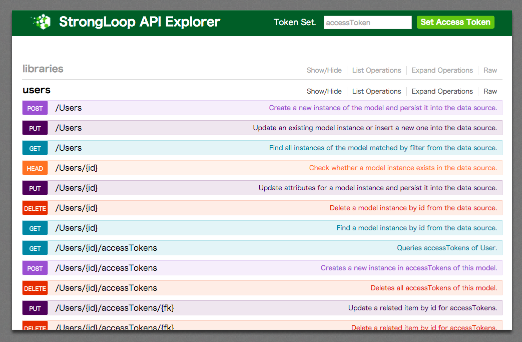

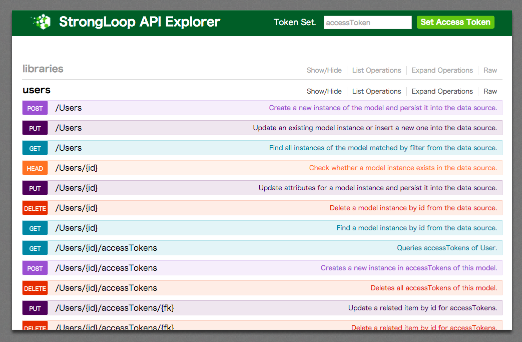

API Explorer

ここまでコマンドラインのHTTPクライアントでAPIを操作してみましたが、実はscafoldした時点でStrong Loop API ExplorerというWebアプリが同時に起動しています。

http://0.0.0.0:3000/explorer

へブラウザでアクセスすると以下の様な画面を閲覧できて実際にAPI操作も行うことができます。

まとめ

loopbackを利用して、アプリケーションの作成とユーザを管理するモデルの作成(それと同時にユーザ操作をするAPIの作成)を行ってみました。

気づかれたかもしれませんが、上までの操作だとモデルを保管する先のストレージを何も設定していない状態なのでアプリケーションの再起動で全て消えます...。

データベースの接続はまた次の機会に。

最近のコメント